Průběhu prací na prvním 100GE DNS stacku, od návrhu přes výběrové řízení až po umístění v datacentru a zprovoznění, se věnoval několikadílný seriál. Díky získanému know-how jsme tak realizovali druhý stack v kratším čase.

V čem se tedy druhý stack liší? Především ve výběru výrobců veškerého hardware, softwarového vybavení, ale také racku a fyzického umístění.

Lokalita a rack

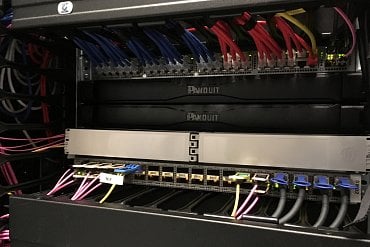

Druhý 100GE DNS stack je umístěn v další pražské lokalitě, konkrétně v datacentru CeColo na Bohdalci. Podívejte se na obrázky:

Rack v zásadě odpovídá parametrům předcházejícího, včetně typů dveří perforace, uzavírání. Je však o 5U vyšší. Konkrétně se jedná o Conteg RSF-48–80/120. Požadavek na rack vyšší než 42U byl dán převážně vyšším routerem. Současně nám to napomůže i k pohodlnějšímu vedení kabeláže. Stejné jsou také vertikální vyvazovací panely a dvojice měřitelných PDU, v tomto případě APC 8886. Protože jsme věděli, že tento nový rack bude mít příkon více jak 5 kW, zdokonalili jsme spolu s instalací racku systém chlazení v datovém centru pomocí principu teplé a studené uličky.

Hardware a software

V rámci požadovaného dodržení diverzity pro klíčové parametry DNS infrastruktury byly ve výběrovém řízení router a switche tentokrát vybrány od společnosti CISCO. Jednalo se konkrétně o

- 2 × 1U 100GE switch Cisco Nexus 3232C

- 2 × 1U 1GE switch Cisco Nexus 3048

- 1 × 6U router Cisco ASR-9904

Router Cisco ASR-9904 je na rozdíl od použitého routeru Juniper MX240 v první lokalitě o 1U vyšší, narostl tedy na celkových 6U. Je osazen 2× Route Switch Processorem 880 a 2× 400G modular line kartami, do kterých jsou vloženy 2+2 MPA moduly 1× 100GE s adaptéry CFP2 to CPAK.

Pro vedení optických vláken jsme opět využili řešení rozvaděče IANOS EDR od společnosti Huber+Shuner v provedení 1U a za použití několika patching modulů single size, Base-2, 6× LCD violet, OM4. ODF jsme tentokrát využili pouze k propojení se zbylou infrastrukturou a síťovými prvky, nikoliv k propojení všech DNS serverů jako v předchozím případě.

Uplink ke všem DNS serverům byl realizován jiným způsobem. A to přímo do switchů Nexus 3232C, pomocí tzv. rozpletů 40Gb MPO na 4× 10Gb LC. Tyto switche byly následně připojeny pomocí 4× MPO/MPO MM OM4 optických kabelů do 100GE adaptérů v routeru.

Switche Nexus 3048 poslouží výhradně pro připojení managementu všech serverů a také pro správu celého stacku.

Konfigurace a celkový počet serverů zůstává stejný, tzn. 30 DNS serverů a jeden server pro management celého stacku. Servery však byly dodány od jiného výrobce, od společnosti HPE v provedení 1U DL360 Gen9. Po softwarové stránce je rozdíl v použitém DNS démonovi. V případě prvního DNS stacku je použit námi vyvíjený Knot DNS server, v druhém DNS stacku je pak implementace od ISC BIND. Díky pravidelnému testování výkonnosti různých DNS démonů víme, že se BIND dlouhodobě neumisťuje na předních místech. Proto plánujeme, že jej v blízké době nahradíme jinou implementací, např. NSD démonem, který slibuje rychlejší odezvy a tím i lepší využití dostupného výkonu.

Konektivita

Hardwarové konfigurace serverů, routeru a jednotlivých switchů jsme stejně jako v případě prvního Velkého stacku optimalizovali primárně pro 100GE uplink do peeringového uzlu NIX.CZ a také do tranzitu. V současné době máme v lokalitě CeColo uplink do tranzitu zatím o rychlosti 10GE. Jednáme však o navýšení na 100GE, kterého bychom se měli dočkat v horizontu jednoho až dvou měsíců.

Závěrem ještě jedna designová perlička.. Na připojení metalických patchcordů jsme použili barvu trikolóry, jako vzpomínku na sté výročí založení naší republiky a dvacáté výročí založení sdružení CZ.NIC. Červená je využita pro vzdálený management iLO, modrá s bílou pro management serverů a správu stacku.

(Původně napsáno pro blog CZ.NIC.)