Datacentra nás vždycky zajímala a v rámci seriálu Na návštěvě jsme jich také pěknou řádku navštívili. DC7 se nachází v průmyslovém areálu mezi Jižní spojkou a nádražím Praha-Hostivař. Jde o nejnovější datacentrum společnosti T-Mobile, které jsme se rozhodli celé projít takříkajíc od sklepa až na střechu.

Přijíždíme do oblasti plné průmyslových hal a blížíme se k datacentru. To se skládá ze dvou částí: černé kancelářské a navazující bílé technické budovy se samotnými datovými sály a vším příslušenstvím. Při pohledu shora má tmavá kancelářská část jasnou podobu číslice sedm, což také odkazuje na sedmé české datacentrum společnosti T-Mobile.

Datacentrum od základů

Jsme ohlášeni, takže nám bezpečnostní služba otevře velkou pojezdovou bránu a my zaparkujeme před hlavním vchodem. Po vyběhnutí několika schodů jsme ve vestibulu legitimováni a procházíme turniketem dovnitř datacentra. Všechno je tu ještě naleštěné a voní to novotou, první část budovy byla dokončena v roce 2018. Naší výhodou je, že je to tu postavené na zelené louce. Vlastně ne doslova, nebyla to louka, ale skládka hlušiny vytěžené při stavbě metra,

vysvětluje nám na úvod Zdeněk Klímek, který nás bude všemi prostory provádět společně s Michalem Koláčkem.

Budova je od začátku navrhována, projektována a postavena jako datové centrum, čemuž odpovídají všechny prvky. Taky jsme se museli přizpůsobit okolnímu prostoru, ale od začátku do konce je to datacentrum.

Takový projekt dává možnost vyhnout se kompromisům vyplývajícím z nutnosti přestavby jiné budovy a je možné vše navrhnout rovnou pro specifické technické potřeby. Jsme jediné datacentrum v Česku certifikované na normu ANSI/TIA-942 rating 3, což znamená plnou servisovatelnost všech komponent za provozu.

To se týká rozvoden, trafostanic, napájení, chlazení a dalších částí, ke kterým se postupně dostaneme. Každoročně certifikaci obnovujeme, což zahrnuje kontrolu nejen technického vybavení budovy, ale také třeba bezpečnostních prvků nebo telekomunikační části.

V této části budovy jsou jen kancelářské prostory a dohled datového centra. Dole pak máme skladové prostory a dok.

Celý prostor je velmi dobře chráněn, hlídá ho dvoučlenný bezpečnostní tým, který má k dispozici přibližně 150 kamer s denním a nočním viděním. Venkovní záznamy uchováváme 30 dnů, vnitřní pak 60 dnů. Jsou k dispozici pro účely vyšetřování případného incidentu, ale zatím nebyly naštěstí potřeba.

Kabely nahoře

Přecházíme do horního patra, které celé slouží jako kabelové koridory. Ty tvoří dlouhé chodby napříč celou budovou, kde jsou na držácích umístěny veškeré kabely pro chod serverů pod námi. Jsou to samostatné koridory, které tvoří devět chodeb pro každou polovinu budovy.

Jde o požárně oddělené úseky, ve kterých se především technici snadno pohybují. Nejsou to žádné podzemní kolektory, je tu sucho, je tu vidět a dobře se tu pracuje.

Datové kabely vstupují do budovy ze třech různých směrů a vystupují v takzvaných meet me roomech, tedy vlastně malých rozvodnách pro optické kabely. Tudy prochází veškerá konektivita a odchází prostupy ve stropech do koridorů, kde jsme byli před chvílí.

Odtamtud jsou pak jednotlivé trasy rozvedeny do datových sálů.

Místnost je to poměrně malá, proto má také své nezávislé hašení plynem Novec 1230. Bylo by zbytečné sem vést část centrálního hašení kvůli takhle malému prostoru.

Chlazení dole

Čeká nás cesta do samotného datového centra, které je v přízemí bílé budovy. Nejprve se zastavujeme v sekci se vzduchotechnikou. Tady za tou zdí už je datový sál, tady je pro něj kompletní chlazení.

Ve velkém prostoru jsou tu vedle sebe naskládány chladicí jednotky, které využívají nepřímý free cooling, tedy chlazení s přirozeným prouděním pomocí venkovního vzduchu. Nepřímý je proto, že vzduch ženeme přes dva výměníky, které jsou v každé téhle velké jednotce. Venkovní vzduch se nikdy nedostane na sál, přesto ho taky filtrujeme.

Ohřátý vzduch ze sálu se nabírá průduchy pod stropem, v chladicí jednotce je na výměníku ochlazen a fouká se zpět do sálu pod podlahou. V té jsou umístěny některé dlaždice s otvory, kterými může dle potřeby proudit vzduch do studené uličky přímo u serverů. Rozdíl teploty studeného a teplého vzduchu je asi jedenáct stupňů a zákazníkům smluvně garantujeme teplotu prostředí 22 stupňů, plus mínus tři stupně.

Každá zdejší chladicí jednotka má špičkový výkon 108 kW, celkem je jich tu na každý sál osm. Jedna je vždy jako záloha, aby mohla za provozu nahradit nějakou jinou třeba po dobu servisu.

Chlazení venkovním vzduchem je dostatečně efektivní po většinu roku, pomáhá mu také adiabatické chlazení, tedy ostřikování výměníků filtrovanou dešťovou vodou. Ta se sbírá ze všech ploch datacentra, na pozemku je zakopaná obrovská nádrž, která je schopna pojmout až 688 tisíc litrů vody. Když teplota venku klesne pod deset stupňů, nemusíme už adiabatiku využívat a na zimu ji vypínáme.

Pokud by ale teplota venkovního vzduchu přesáhla 28 stupňů Celsia, je potřeba zapojit klasické kompresorové chlazení. To ale nastává v našich podmínkách velmi zřídka, zhruba v pěti procentech dnů za rok.

Indikátor energetické efektivity, anglicky Power Usage Effectiveness (PUE), ukazuje poměr celkové spotřeby ku spotřebě samotného IT vybavení. Umíme smluvně garantovat PUE do 1,3,

vysvětluje Klímek. Pokud by chlazení využívalo trvale klasických klimatizací, nebylo by možné dosáhnout takové hodnoty. To bychom se určitě pohybovali nad 1,5.

Mezi chladicími jednotkami stojí malá nádrž, která připomíná domácí bojler. Pomocí tepelného čerpadla dále využíváme odpadní teplo ze sálů a ohříváme médium pro předehřev dieselů.

Agregáty se udržují neustále zahřáté, aby se zajistil jejich bezproblémový start. Obvykle se to dělá pomocí elektrických patron, které spotřebovávají spoustu energie.

Když k tomu využijete teplo, které už stejně máte, dokážete podle Klímka uspořit na předehřevu jednoho dieselu stovky tisíc korun za rok. Ceny energií rostou a v plné konfiguraci tu budeme mít osm dieselů, takže návratnost je velmi dobrá.

Teplo se tu samozřejmě využívá také na vytápění kanceláří a dalších prostor datacentra. Veškeré prostory jsou vyhřívány pomocí tepelných čerpadel využívajících zbytkové teplo ze sálů.

Uvažují tu i nad dalšími možnostmi, jako je vytápění okolních hal v průmyslovém areálu. S rostoucími cenami energií dávají takové úvahy čím dál větší smysl.

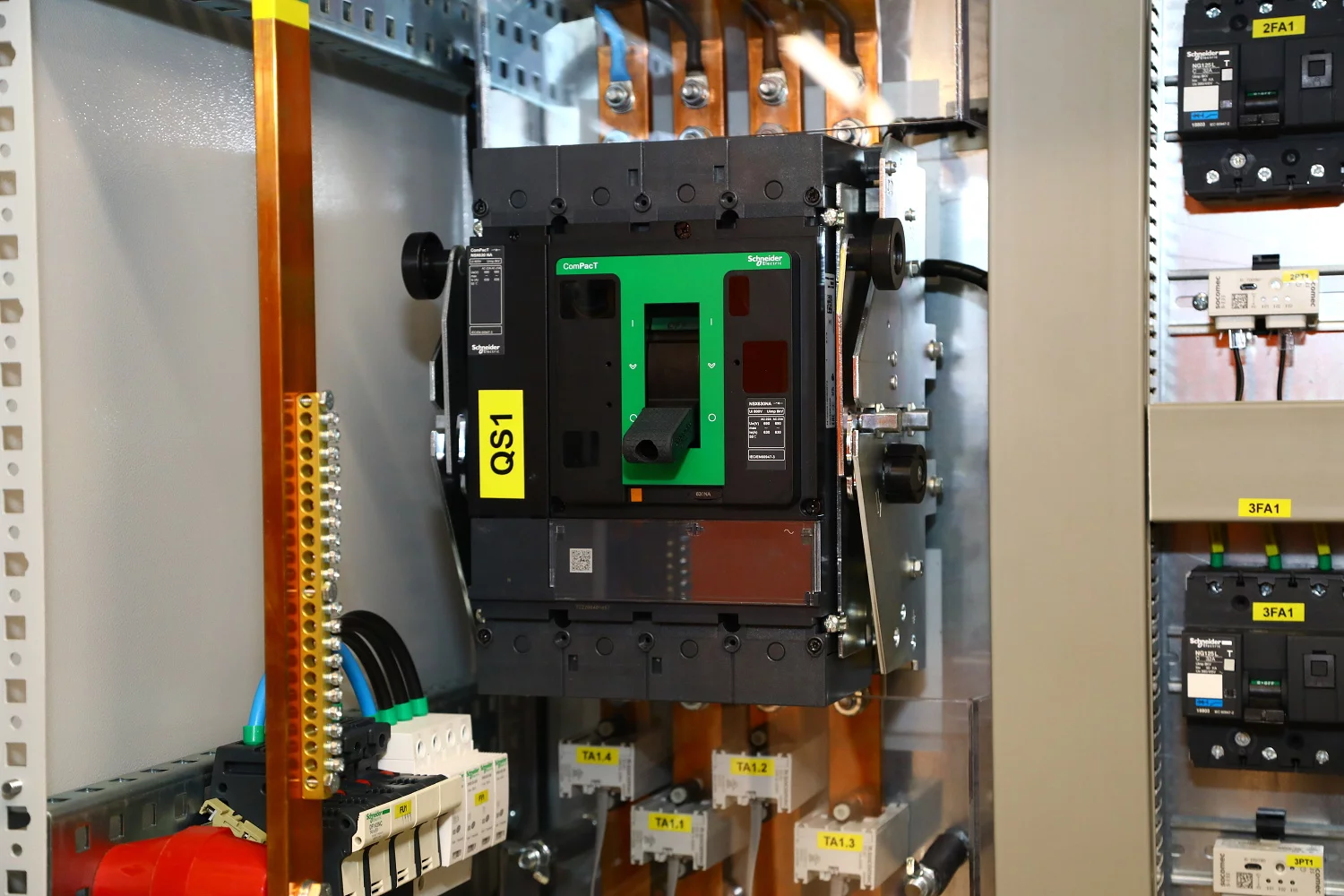

Životodárná energie

Datacentrum je napájeno ze dvou nezávislých rozvoden Chodov a Malešice. Distribuce si pak určuje, ze které rozvodny jsme připojeni. Standardně je to Chodov, ale při loňském pražském blackoutu nás po půl hodině přepojili na Malešice.

Po dobu výpadku je nutné zajistit náhradní napájení, což zde zajišťují baterie a už zmíněné dieselové generátory.

V současné době jsou pro datacentrum k dispozici dvě funkční rozvodny a třetí se připravuje. Centrem jsou samozřejmě UPS, v této máme šest modulů od společnosti Vertiv a ve druhé pak používáme značku Socomec.

Je to proto, aby datacentrum nebylo závislé pouze na jednom dodavateli takto důležitých komponent. UPS pracují v režimu dvojité konverze, kdy se neustále dobíjejí baterie a souběžně se filtrovaná energie dostává k rackům. Existují i jiné režimy provozu, ale u nich je riziko delší doby náběhu. Jsou to sice desítky milisekund, ale už i to může mít vliv.

Pro uskladnění energie se používají klasické olověné baterie, které jsou především cenově výhodné. Testujeme je při pravidelných měsíčních zkouškách a také ve velkém ročním blackout testu. Pravidelně se pak zkoušejí i jednotlivé články, jestli mají stále správnou kapacitu.

Vzadu v baterkárně vidíme i 48voltový systém určený pro stejnosměrné telekomunikační rozvody. Primárně to využíváme pro interní účely, ale umíme je nabídnout i běžným zákazníkům.

Pokud dojde k výpadku vnějšího zdroje vysokého napětí, veškerá technika běží dál a systém čeká patnáct sekund na to, zda nedojde k obnovení napájení. Pokud ne, vyšle se signál k nastartování dieselů.

Ty potřebují přibližně 15 sekund k plnému rozběhu, takže datacentrum přebírá plnou napájecí zátěž zhruba do 40 sekund od výpadku. UPS mají v tuto chvíli kapacitu na 47 minut provozu, což je obrovská rezerva, která je ale potřebná pro opakované výpadky v krátkém časovém úseku. V jiném datacentru už se nám staly opakované výpadky a v takové situaci by se nemusely stihnout dobíjet baterie.

Energetické rozvody jsou rozlišeny barevně. První rozvodna je modrá, druhá oranžová a připravuje se černá. Je to vidět i na datových sálech, kde máme barevně oddělené všechny rozvaděče.

Barva se drží celou trasu až do racku, aby měli technici jednodušší orientaci v jednotlivých napájecích větvích. Třetí rozvodna je připravená, někdy na přelomu roku ji budeme spouštět.

Datacentrum má zatím smluvně zajištěnou dodávku energie až do výše 3 MW. Projektově jsme schopni naškálovat až na 8 MW, každý sál má kapacitu 700 kW.

To zahrnuje napájení a samozřejmě také chlazení, které rozhoduje o celkové efektivitě.

Přecházíme do další místnosti, která je téměř celá vyplněna obrovským motorem. V současné době jsou už dva diesely v provozu, třetí je připravený. Zdejší agregáty tvoří šestnáctiválce o objemu 60 litrů se čtyřmi turbodmychadly. Motory jsou předehřívané na 40 stupňů Celsia pomocí okruhu, který jsme viděli v místnosti s chladicími jednotkami. Výkon generátoru je 1,6 MW, respektive 2000 kVA při spotřebě 550 litrů nafty za hodinu při plném zatížení. Motor má odpružení a stojí na betonovém sarkofágu, který má vlastní piloty a je fyzicky oddělen od zbytku datacentra, aby se do něj nepřenášely vibrace.

Na motorech je potřeba provádět klasický servis, který zahrnuje například výměnu oleje a filtrů. To je běžná věc, mechanici si z auta připojí hadice, olej vysají a načerpají nový.

Generální oprava motoru by měla nastat až po 50 tisících motohodinách, ale k tomu zřejmě nikdy nedojde. Aktuálně máme za pět let natočeno 86 motohodin.

Většinu doby diesely stojí, prakticky nikdy nedosáhnou své provozní životnosti. Neznám datové centrum, které by muselo řešit výměnu dieselů kvůli technologickému zastarání.

Centrální nádrž na naftu je zakopaná na pozemku mezi datacentry a pojme 21 tisíc litrů nafty. To je nádrž jen pro stávající datacentrum, pro druhé budeme přidávat samostatnou nádrž.

Používá se tu arktická nafta bez bio příměsí a její množství je udržováno pro 40 hodin plného provozu datacentra. Každý měsíc testujeme všechny diesly na půl hodiny běhu, abychom si byli jisti, že vše funguje.

Jednou za rok se pak dělá velký blackout, kdy je simulován kompletní výpadek vysokého napětí. Naftu pravidelně testujeme, zda má správné vlastnosti.

Datová centra spadají pod kritickou infrastrukturu státu a mají tudíž prioritně zajištěný přísun nafty. Na prvním místě je armáda, pak jsme my společně třeba s nemocnicemi.

Na základě telefonické objednávky je společnost Čepro schopná do tří hodin přistavit cisternu s další naftou.

Hašení

Důležitou součástí každého datacentra je také požární bezpečnost, která má za úkol ochránit drahý majetek klientů. Základem jsou protipožární dveře, které musejí zůstávat stále zavřené. U nás máme podle typu prostor garantovanou odolnost až po dobu 60 minut požáru.

Všude po datacentru jsou rozmístěna požární kouřová čidla, která jsou jak na stropě, tak i pod zdvojenou podlahou, kde je samozřejmě také riziko požáru. Všude, kde vidíte na podlaze červené tečky, jsou umístěna kouřová čidla.

V datacentru je nainstalován také systém VESDA (Very Early Smoke Detection Apparatus), který sám průběžně natahuje vzduch a pomocí laserového paprsku vyhodnocuje, zda se v něm nevyskytují kouřové částice. Je to nejcitlivější řešení dostupné na trhu.

Hasicí plyn Inergen je uložen v tlakových lahvích a jde o směs argonu, dusíku a oxidu uhličitého. Při hašení dojde ke snížení hladiny kyslíku přibližně na dvanáct procent, což spolehlivě uhasí jakýkoliv požár.

Systém je plně automatický a podle rozměru hašených prostor se použije potřebný počet lahví. Do objemu jsou započítány i prostory pod podlahou a klimatizační jednotky.

Celý systém je pravidelně kontrolován a jednou za deset let pak bude následovat detailnější kontrola tlakových lahví.

Ke spuštění hasicího systému dochází plně automaticky. Na základě informací z kouřových čidel a systému VESDA je vyhlášen poplach a obsluha datacentra má minutu na případné odložení o pět minut. Je pak čas zkontrolovat prostory a rozhodnout o dalším postupu. Pokud by se jednalo o chybu čidla, je možné poplach odstavit.

Pokud obsluha nezasáhne, dojde k automatickému uhašení.

Spuštění probíhá pomocí samostatných lahví s dusíkem, které natlakují pomocný systém a ten pomocí jehel ve ventilech otevře hlavní lahve do hasicího okruhu. Systém je možné spustit i manuálně, když by došlo k nějakému výpadku systému čidel.

Hašení vždy probíhá za plného provozu datacentra, žádná technologie se při něm nevypíná. Výjimku mají hasiči, kteří by mohli rozhodnout o částečném nebo úplném odstavení napájení.

V sále

Přicházíme do jednoho ze čtyř datových sálů, které se v této budově nacházejí. Vstup je zajištěn pomocí čtečky karet doplněné o biometriku, která snímá otisk prstu příchozího. Do technologických částí je pak potřeba ještě zadat PIN. Přístup do různých částí je oddělen.

Každý ze sálů má 350 metrů čtverečních, do každého by se vešlo až 146 racků o šířce 80 cm. Pokud by šlo o 60cm racky, těch by se do každého sálu vešlo až 195. Obvykle prostory dělíme na menší sekce podle přání zákazníků, takže je ve skutečnosti kapacita o něco menší. Pokud by ale přišel jeden velký zákazník, který by sál využil celý, má možnost ho osadit takovým množstvím racků.

Všechny racky mají hloubku 120 cm a výšku 47 U. Standardně poskytujeme celý rack, ale umíme nabídnout i oddělenou polovinu nebo čtvrtinu racku.

Veškerá kabeláž vede nahoře pod stropem, tedy jak síťová konektivita, tak i napájení jednotlivých racků. Záleží na tom, co si zákazník objedná, ale pokud chce plnou redundanci, umíme mu garantovat souběh až uvnitř jeho racku.

I tady jsou vidět různé barvy rozvaděčů, stejně jako v rozvodnách. Každý výstup je dohledován a měřen, obsluha přesně zná stav každého jističe.

U serverů si pak prohlížíme perforované dlaždice na podlaze, kterými proudí studený vzduch do uličky. Počet se volí podle toho, jaká je zátěž v konkrétním racku. U malé zátěže stačí jedna perforovaná dlaždice, případně je přidáváme.

Proudění vzduchu je možné také usměrňovat pomocí záslepek v prázdných pozicích mezi servery. Dbáme na to, protože to zvyšuje efektivitu chlazení.

Zákazníci mají přístup do monitoringu a mohou sledovat teplotu vzduchu v uličce i při nasávání do racků.

Standardně se tu používají racky společnosti Triton, ale v nabídce jsou i další možnosti. Tady vidíte jak klasickou mechanickou kliku se zámkem, tak i elektronickou variantu na kartu, která umožňuje otevřít najednou celou řadu.

Zákazník pak má sám možnost zámky ovládat a spravovat například uživatele, kteří mají do racků přístup.

Dvojitá podlaha má nosnost dvě tuny na metr čtvereční, základová deska pod ní unese pět tun na metr čtvereční. Každý zákazník má k dispozici dvě napájecí větve a v racku je umístěn rozbočovač PDU se dvěma jističi. Základní varianta je skutečně jen jednoduchá sada zásuvek, je možné mít ale i chytřejší řešení s monitoringem a možností na dálku odpojovat jednotlivé výstupy.

Technici datacentra mají přístup do většiny racků, aby mohli provádět menší zásahy na žádost zákazníků. Jsou ale i zákazníci, kteří mají uzavřený prostor, vlastní kamerový systém a přístup je tam možný jen po kontaktování jejich bezpečnostního centra.

Takoví zákazníci jsou typicky z bankovního sektoru, který má vždy velmi přísně nastavená pravidla.

Na stropě si prohlížíme prostupy do horních kabelových koridorů. Dříve se musel udělat otvor, po protažení kabeláže se musel zaházet a poté bylo třeba zajistit požární revizi.

Modernější systém umožňuje za provozu volnými otvory protahovat další kabely. Uvnitř je speciální rukáv, který se při požáru nafoukne a otvor z obou stran ucpe.

Pod stropem sledujeme průběh hasicího systému, který tu má nasazené takzvané tiché trysky bránící poškození rotačních disků vibracemi způsobenými přílišným hlukem.

Na stavbě

Dostáváme helmy, vesty, bezpečnostní pokyny a vyrážíme na poslední část naší prohlídky: na stavbu druhého křídla datacentra. To se začalo stavět v květnu 2023, takže stavba běží přibližně šest měsíců a je zhruba v polovině. Jde o úplně totožné datacentrum, opět čtyři sály, až čtyři rozvodny a čtyři diesely. Konfigurace se samozřejmě bude postupně rozšiřovat, na začátku počítáme se dvěma diesely a další se budou přidávat, jakmile budeme růst.

Budova se staví podle stejného projektu, na kterém byly provedeny jen velmi malé úpravy plynoucí ze zkušeností s předchozím provozem prvního datacentra. Stavba druhé části tak byla výrazně jednodušší, protože celý projekt byl hotový. Hodně věcí děláme sami, stavba nám dodává jen samotnou konstrukci a zbytek je v naší režii.

Řadu zařízení bylo potřeba objednat i rok dopředu, například chladicí jednotky a dieselagregáty.

V tuto chvíli je hotová hrubá konstrukce z prefabrikovaných betonových bloků, stavějí se vyzdívky, připravují izolace a paralelně dělníci pracují na střeše. Jsou tam vidět sloupky pro osazení fotovoltaikou, která by pak měla být i na původní budově.

Po plném osazení bude solární elektrárna schopna dodat ve špičce 220 kW energie. Proti našemu odběru je to jen malá část, ale alespoň pomůžeme s výrobou obnovitelné energie.

Uvnitř rozestavěného datacentra jsou hotové už některé stěny, které jsou rozebiratelné, aby bylo možné přes ně později dostat například chladicí jednotky. Dorazí v kuse a je potřeba je sem nasunout. Budeme je také instalovat postupně, jak budeme novou část zabydlovat.

Opět se tu počítá s postupným osazováním včetně trafostanic, rozvoden a dieselagregátů. Obě části jsou od začátku stavěny jako modulární.

Jakmile bude stavba ukončena, budou všechny tři části budovy propojený dveřmi a budou průchozí.

Přípravou celého projektu se zabývala společnost Systeming CZ. Každý týden probíhají kontrolní dny, kterých se účastní také projektanti, abychom si byli jisti, že je vše ve správném stavu.

Rozšíření je plánováno i s ohledem na budoucnost, protože stávající centrum Nagano je postupně utlumováno a už není nabízeno novým zákazníkům. Také s ohledem na nižší efektivitu, protože má horší PUE.

Prohlídku končíme na střeše, odkud máme vyhlídku na Malešice a Jižní spojku. Je čím dál složitější najít v Praze prostor, kde postavit nové datacentrum. Zejména z pohledu napájení je to těžké a do budoucna to bude ještě horší.

Na střeše vidíme výdechy chlazení a máme rozhled po celém okolí včetně nové stavby. Je to taková hračka pro velké kluky,

říká nám náš průvodce při loučení. Asi jste si všimli, že nás to děsně baví,

dodává nadšeně. Odcházíme a už přemýšlíme, koho navštívíme příště.

(Autorem fotografií je Karel Choc.)