Když si pojem „Exascale Study“ necháte vyhledat třeba Googlem, zjistíte, že problému se věnují prakticky všichni. Od národních institucí průmyslových velmocí, přes význačné i méně význačné univerzity, nadnárodní IT korporace až po všemožné výrobce hardwaru, který bude v příští generaci superpočítačů použit. A také softwaru.

Problémy hardwarové jsou stejné prakticky od chvíle, kdy se superpočítačům začal věnovat Seymour Cray. Je potřeba jim dodat dostatek megawattů výkonu, je potřeba jim dodat co nejvíce chladícího potenciálu a je potřeba je co nejefektivněji pospojovat. Jednotlivé procesory (CPU, GPU či jiné) do uzlů, uzly do větších celků, ty do ještě větších celků, až vznikne jeden obří počítač. Superpočítač.

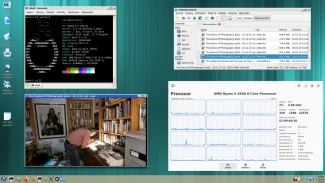

Vedle toho ale vznikají i problémy softwarové, neboť s takto rozporcovanou výpočetní kapacitou je potřeba přistupovat k softwaru jinak než u běžných serverů či nedejbože domácích PC. Národní laboratoře v Los Alamos (USA) tak aktuálně testují právě tento aspekt na clusteru s 3000 procesorovými jádry typu Raspberry Pi (750 počítači) uspořádaných v Blade modulech od společnosti BitScope Designs. Příští rok chtějí počet navýšit na 40 tisíc jader.

Pro Los Alamos představuje tento cluster možnost vůbec nějak vyvíjet technologie pro Exascale éru. Není možné, aby si vědci vyhradili nějaký stávající superpočítač na své experimenty pro příští generaci, čas současných superpočítačů je vzácný a drahý.

Hlava 22 v ExaFLOPS éře

Jak poznamenává Raspberry v článku tomuto tématu věnovanému, když chtějí v Los Alamos psát operační systém, síťové věci či cokoli jiného pro příští generaci superpočítačů s obrovským počtem uzlů / jader (i ve srovnání se současnými superpočítači), tak nemají na čem testovat. A dokud takový stroj nebude postaven, nic se nezmění. A jelikož problémy k řešení jsou zejména v oblasti paralelismu, synchronizace a dalších aspektech související s obřím počtem uzlů v budoucích superpočítačích, není problémem nízký výkon jednoho uzlu / procesoru na testovacím „mini superpočítači“ s deseti tisíci stroji Raspberry Pi. Nemluvě o podstatně snadnější údržbě takového „malinového superpočítače“.

Na tomto speciálním počítači v Los Alamos tak budou prováděny návrhy, vývoj, odstraňování chyb i testování nových síťových architektur, nového systémového softwaru. Výhodou Raspberry Pi je to, že na něm běží prakticky vše, co se provozuje na superpočítačích (myšleno GNU+Linux + další případné nástroje), přičemž proporčně má Raspberry Pi adekvátní výkon CPU, velikost RAM a propustnost síťového rozhraní tomu, co odpovídá budoucím superpočítačům, podobně jako malý model architekta odpovídá budoucí velké budově.

Výpočetní clustery s RPi nejsou nic nového

Když se na chvíli oprostíme od enterprise sféry, tak stavění clusterů z minipočítačů typu Raspberry Pi není nic nového. Takové stroje si tradičně staví mnoho fanoušků už od dob prvního Raspberry Pi v roce 2012.

Na konferenci SuperComputing 17 (SC17), kde svoje řešení ukazovala i BitScope, se prezentovala též firma OpenIO se svým softwarovým řešením a clusterem na bázi odlehčených minipočítačů Raspberry Pi Zero.

Berkeley Lab zase ukázaly kontejnerovou platformu Singularity běžící na clusteru Raspberry Pi 3. A v neposlední řadě také třeba Edinburgh Parallel Computing Center se svým clusterem též na bázi Raspberry Pi 3.

Ideální levné řešení?

Zkrátka minipočítače typu Raspberry Pi se jeví býti vhodným řešením pro vývoj řešení pro spousty typů nasazení. Od menších věcí až po superpočítače příštích generací poskytují levnou, téměř každému dosažitelnou platformu pro vývoj potřebných softwarových technologií na otevřených standardech. Zejména pokud se zvolí fyzicky menší verze typu současného Raspberry Pi Compute Module 3.

Je však potřeba ohlídat si dostatečné chlazení a nenahustit příliš mnoho minipočítačů do příliš malého prostoru. Také je vhodné vyhnout se použití úložišť na bázi méně spolehlivých microSD kartiček a volit raději rychlé připojení kabelem. Tomu přispívá podpora bootování po síti.