Koronakrize nám způsobila značné komplikace v realizacích. Původní plán navrhnout a pořídit potřebný materiál (ODF, transceivery, metalickou a optickou kabeláž apod.) během prvního kvartálu a začít s realizacemi hned na jaře, vzal za své. Vzhledem ke značným výpadkům ve výrobě některých komponent byly dodací lhůty násobně delší a tak jsme museli jednotlivé realizace přeorganizovat. Fyzicky jsme mohli začít pracovat v datacentrech až v červnu. Dnešní část se bude věnovat navýšení kapacity linek mezi našimi primárními datacentry v Praze.

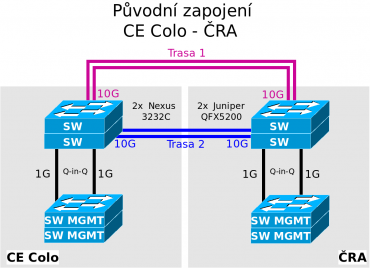

Původní zapojení okruhů – 2× 10 Gbps

Mezi datacentry ČRA Tower a CE Colo v Praze máme pronajaté dva nezávislé dvouvláknové okruhy od různých dodavatelů, které jsou vedené odlišnými trasami. Oba okruhy jsou tzv. „Dark Fiber“, tedy nenasvícená optická vlákna. To znamená, že není definována rychlost, jakou budeme na linkách využívat. Rychlost je definována použitými transceivery na obou koncích okruhů.

Původní zapojení mělo kapacitu 2× 10 Gbps, kdy každý okruh byl zapojen do jednoho ze dvou páteřních switchů v dané lokalitě. Celkově jsme tedy měli díky LACP (Link Aggregation Control Protocol – neboli metodě kombinující více fyzických síťových připojení do logické linky, jež poskytuje odolnost proti výpadku a zvyšuje rychlost) mezi pražskými datacentry k dispozici 20 Gbps.

Tato kapacita však již nebyla dostatečná, neboť realizací privátního sálu v ČRA Tower a novou koncepcí sítě jsme díky postupné obměně access switchů začali zapojovat všechny servery dvěma 10Gbps uplinky. Jako první bylo (nepočítaje DNS anycast) tímto způsobem zapojeno produkční prostředí registru FRED a servery pro provoz služby mojeID v datacentru ČRA Tower a neveřejné lokalitě. Dalším podstatným důvodem bylo, že v obou lokalitách provozujeme dva velké 100Gbps DNS stacky.

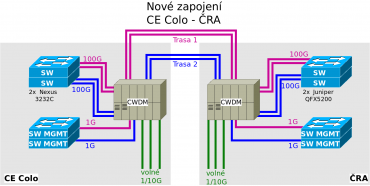

Nové zapojení okruhů – CWDM a něco navíc

Začali jsme tedy uvažovat nad upgradem na 2× 100 Gbps. Na tom by nebylo nic těžkého. Díky průběžným upgradům i páteřních switchů v obou lokalitách jsme měli k dispozici dostatek 100Gbps portů. Stačilo by tedy na současných okruzích vyměnit 10Gb SFP+ LR transceivery za 100G QSFP28 LR. Ale tak jednoduché to nebylo.

V nové koncepci sítě jsme totiž začali zcela oddělovat MGMT síť, tedy síť, kam jsou připojené remote-managementy serverů, switche, konzolové switche apod. Tuto MGMT síť jsme začali jako první používat právě v privátním sálu v ČRA Tower, kde jsme společně s optickou infrastrukturou natáhli i metalickou kabeláž mezi páteřními a access MGMT switchi. Aby byla dostupná i v datacentru CE Colo a také v neveřejné lokalitě, řešili jsme to pomocí technologie Q-in-Q, díky které je možné tzv. „zabalit“ vybrané VLANy do jiné a tuto jedinou „poslat“ mezi lokalitami. Řešení je to sice pěkné, ale popírá to náš záměr mít MGMT zcela oddělenou.

Bylo tedy potřeba najít takové řešení, jak po pronajatých okruzích provozovat 100 Gbps a další kanál s 1 Gbps čistě pro MGMT síť. Jelikož v obou lokalitách používáme modulární ODF, které umožňuje osazení různými typy modulů, oslovili jsme dodavatele, zda jsou takové řešení schopni dodat.

A skutečně takový modul měli k dispozici na bázi tzv. „band splitteru“ pro 1310/1550 nm. Pro 100 Gbps by se tedy použil segment 1310 nm a pro přenos 1/10 Gbps pak 1550 nm. Pro obě trasy bychom museli mít logicky celkem čtyři kusy těchto modulů.

Takové řešení by sice uspokojilo naše aktuální potřeby, ale nechtěli jsme být limitováni jen jedním dalším kanálem. Proto jsme uvažovali další možnosti rozšíření. Dostali jsme tedy nabídku na dvě rozšíření:

- CWDM-MUX se čtyřmi kanály + 1310 nm pro 100 Gbps

- CWDM-MUX s osmi kanály + 1310 nm pro 100 Gbps.

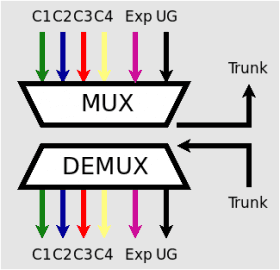

Dali jsme přednost ekonomičtější variantě, tedy řešení se čtyřmi kanály, které se dodává v jedné kazetě. Jak to vlastně funguje? Uvnitř každého modulu je MUX. Ten kombinuje více optických signálů v jednom optickém vlákně za použití různých vlnových délek – barev. Jeho úkol je jednoduchý. Z připojeného okruhu „rozdělí“ vlnové délky na jednotlivé LC konektory. Stejně jako v původní variantě 100 Gbps + 1 Gbps, musíme mít v každém datacentru dva moduly, každý pro jeden okruh.

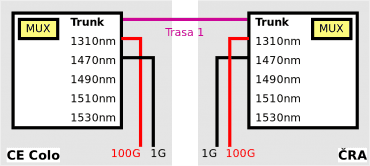

Jak ukazuje schéma níže, do prvního LC konektoru je přiveden TRUNK, tedy vlákno jednoho okruhu. Na druhém konektoru je k dispozici 100 Gbps na standardní vlnové délce 1310 nm. Na zbylých čtyřech pak vlnové délky 1470, 1490, 1510 a 1530 nm pro použití 1/10 Gbps. Takto jsou zapojeny všechny moduly.

My tedy reálně využijeme zatím 1310 nm pro 100 Gbps a 1470 nm pro 1 Gbps MGMT síť. Obrázek níže ukazuje nové zapojení okruhů mezi datacentry při využití CWDM technologie.

Transceivery a zprovoznění

Ale to není všechno, ještě zbývá použít vhodné transceivery. Standardní 100G QSPF28 transceiver a různě „barevné“ 1G SFP transceivery jsou běžně k dostání. Je však důležité sledovat ještě jeden důležitý parametr každého transceiveru. Tím je power budget, tedy do jakého maximálního útlumu výrobce garantuje jeho funkčnost. Velikost útlumu je závislá na prvcích, které jsou po cestě, ale také na délce tras (včetně celkové délky přímo v datacentrech).

Museli jsme tedy zjistit, jaké jsou útlumy na trasách a k nim připočítat útlumy i na modulech MUX. Útlumy tras s náměrem po datacentrech vycházely následovně:

Trasa 1

- 1310 nm – 7,65 dB

- 1550 nm – 5,48 dB

Trasa 2

- 1310 nm – 7,66 dB

- 1550 nm – 5,01 dB

Připočtením 2× 1,4 dB útlumu na modulech MUX se dostáváme na nejhorší útlum cca 10,46 dB., což už je poměrně hodně. Pro srovnání, u běžného 100Gbps LR transceiveru pro délku 10 km se pohybuje power budget okolo 4–5 dB. Museli jsme tedy najít výkonnější transceiver, byť délka 10 kilometrů by dostačovala.

Vybírali jsme mezi různými dodavateli, včetně dodavatele modulů MUX. Nakonec jsme pořídili transceivery 100G QSFP28 ER4 with dual CDR, 40 km, LC-Duplex, λ1296–1309 nm s power budgetem 18 dB od dodavatele, který nabídl nejnižší cenu a právě nejvyšší power budget.

Máme celkem pět kusů, abychom měli jeden náhradní. Jelikož se jedná o poměrně drahé a nepříliš běžné transceivery, mohou mít delší dodací lhůtu. Pro MGMT síť jsme pak vybrali 1G SFP CWDM EX, 40 km, LC-Duplex, λ1470nm s power budgetem 19dB. Pořídili jsme samozřejmě také pět kusů.

Oba propoje jsme díky LACP mohli postupně přepojit během dne a bez dopadu na celou infrastrukturu. Vlastně jeden dopad to přece jen mělo, namísto 2× 10 Gbps jsme „rozsvítili“ 2× 100 Gbps! Na obrázku níže jsou nové 100 GE transceivery ty s tím červeným držákem.

V příští části o upgrade síťové infrastruktury shrnu všechny zbylé letošní úpravy v datacentru CE Colo a také novinky v naší neveřejné lokalitě.

(Napsáno pro blog CZ.NIC.)